Reflexión de miércoles

El software ya no se compra: se alquila, se actualiza, se vigila. Vivimos en una economía donde los sistemas operativos se transformaron en servicios y los usuarios en fuentes de datos. Pero mientras Windows, macOS, Android e iOS dominan la superficie visible, otro sistema gobierna silenciosamente el corazón del mundo digital.

Del producto al servicio: cómo el capitalismo digital cambió las reglas del mercado

Durante décadas creímos que el éxito tecnológico se medía por la cantidad de pantallas en las que aparecía un logotipo. Pero el poder real no está en la visibilidad, sino en la infraestructura. Linux, nacido como un proyecto comunitario y gratuito, no conquistó el escritorio, pero hoy sostiene el funcionamiento del planeta. Es el sistema operativo de Internet, de la nube, de los servidores, de los teléfonos, de las máquinas industriales y de los dispositivos inteligentes que nos rodean. Ganó donde los demás ni siquiera miraban.

1. Del software como producto al servicio como negocio

El capitalismo digital cambió el modo en que concebimos el software. Durante el siglo XX, los sistemas operativos eran productos: se compraban, se instalaban y duraban hasta que quedaban obsoletos. Pero a medida que la red se volvió omnipresente, el negocio se desplazó hacia el servicio continuo. Hoy no pagamos por un sistema, sino por su actualización, sincronización y permanencia.

La vieja relación de oferta y demanda se rompió. Jeremy Rifkin ya lo había anticipado en La era del acceso: el capitalismo contemporáneo ya no vende bienes, sino experiencias sostenidas. Windows, macOS, Android y iOS no son realmente sistemas operativos, sino portales a ecosistemas cerrados donde cada acción se monetiza. El software se volvió una suscripción; el usuario, un flujo de ingresos recurrentes.

Este cambio alteró los fundamentos del mercado. El producto dejó de tener un precio único y pasó a generar rentas constantes. Y donde hay renta, hay vigilancia. Como explicó Shoshana Zuboff, en el capitalismo de la vigilancia el valor no surge de la venta directa, sino de la captura y predicción de la conducta. El software ya no se limita a servir: observa, mide y anticipa.

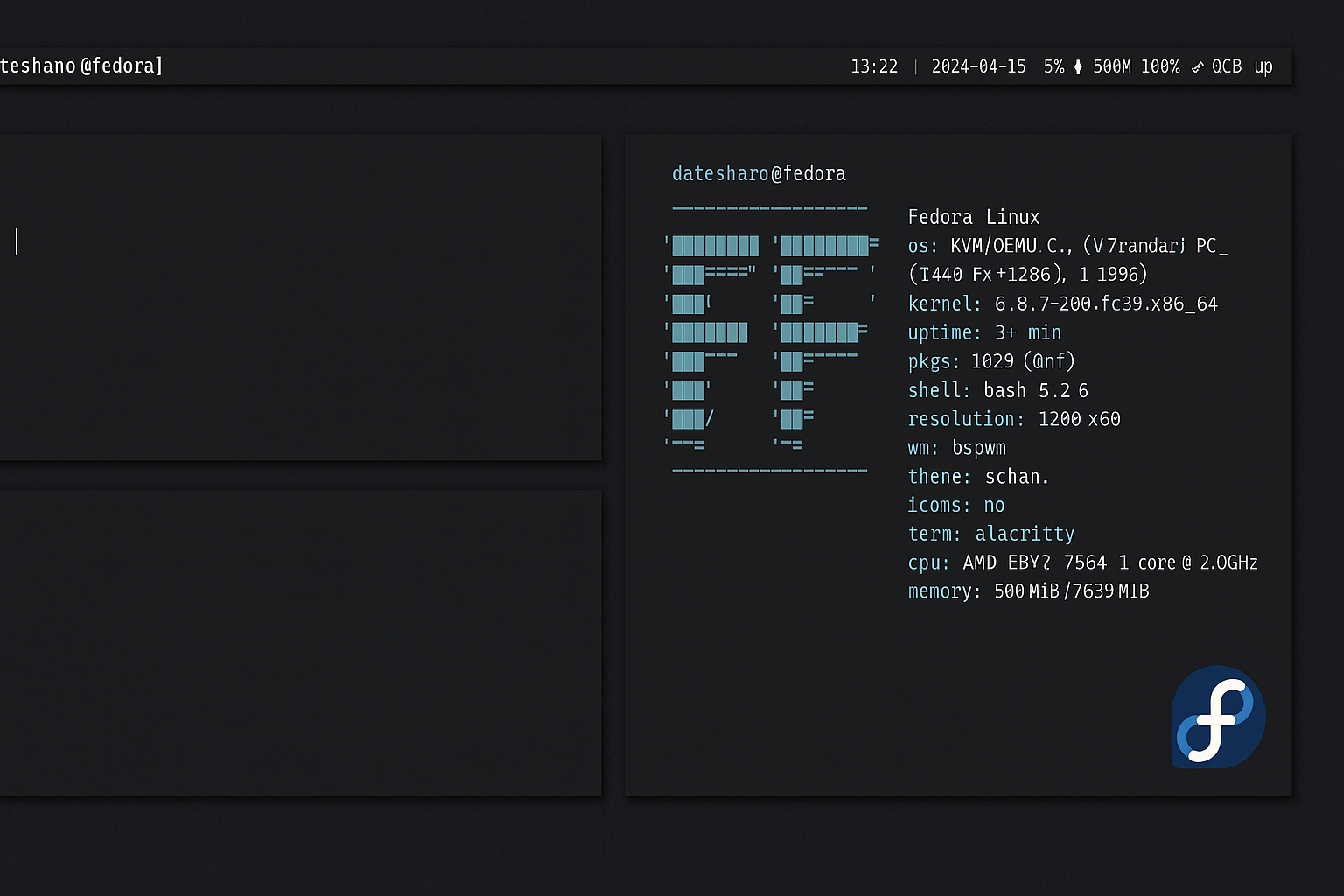

2. El triunfo invisible de Linux

Mientras las grandes corporaciones transformaban el software en servicio, Linux seguía expandiéndose en silencio. Según W3Techs y Netcraft (2024):

- El 96% de los servidores públicos del mundo corren Linux.

- El 100% de las 500 supercomputadoras más potentes usan Linux.

- El 70% de los smartphones lo utilizan mediante Android.

- El 80% de los dispositivos embebidos (routers, autos, televisores) ejecutan variantes de Linux.

- Y aunque apenas un 3% de los escritorios lo usan, controla el 99% de la infraestructura que los conecta.

Su victoria no fue comercial, sino estructural. Linux no necesitó conquistar el escritorio porque ya dominaba todo lo demás: los cimientos físicos y lógicos del capitalismo digital. En un mundo interconectado, el poder no está en la interfaz, sino en el back-end. Y ahí, Linux reina sin oposición.

Eric S. Raymond lo explicó en su ensayo The Cathedral and the Bazaar: el software libre prospera porque distribuye la inteligencia y la innovación entre miles de colaboradores. No necesita jerarquía ni control centralizado; su ventaja es la cooperación. Mientras los sistemas propietarios defienden su código, Linux libera el conocimiento como recurso común. Esa apertura le permitió evolucionar más rápido que cualquier producto cerrado.

3. El mercado que se volvió red

La economía digital ya no responde a la lógica clásica de oferta y demanda. En el siglo XXI, lo que importa no es cuántas licencias se venden, sino cuántos usuarios permanecen conectados. El valor se mide en retención, no en transacción. Es el paso de la economía del producto a la economía de la plataforma.

Manuel Castells lo sintetizó en La era de la información: las redes son la nueva estructura del poder. Las corporaciones tecnológicas no compiten por el precio, sino por la capacidad de crear entornos cerrados donde el usuario se convierte en nodo cautivo. Apple no vende teléfonos, vende continuidad. Microsoft no vende sistemas, vende integración. Google no vende Android, vende el acceso a tu vida digital.

En este contexto, Linux representa lo opuesto: un sistema que no captura, no suscribe, no cobra. Su valor radica en el uso libre, en la cooperación descentralizada, en la posibilidad de modificar sin pedir permiso. Y esa libertad, paradójicamente, es lo que le permitió conquistar los espacios donde el control económico es más estricto: los centros de datos, los servidores empresariales, las redes globales.

4. Capitalismo de plataformas y privatización del entorno digital

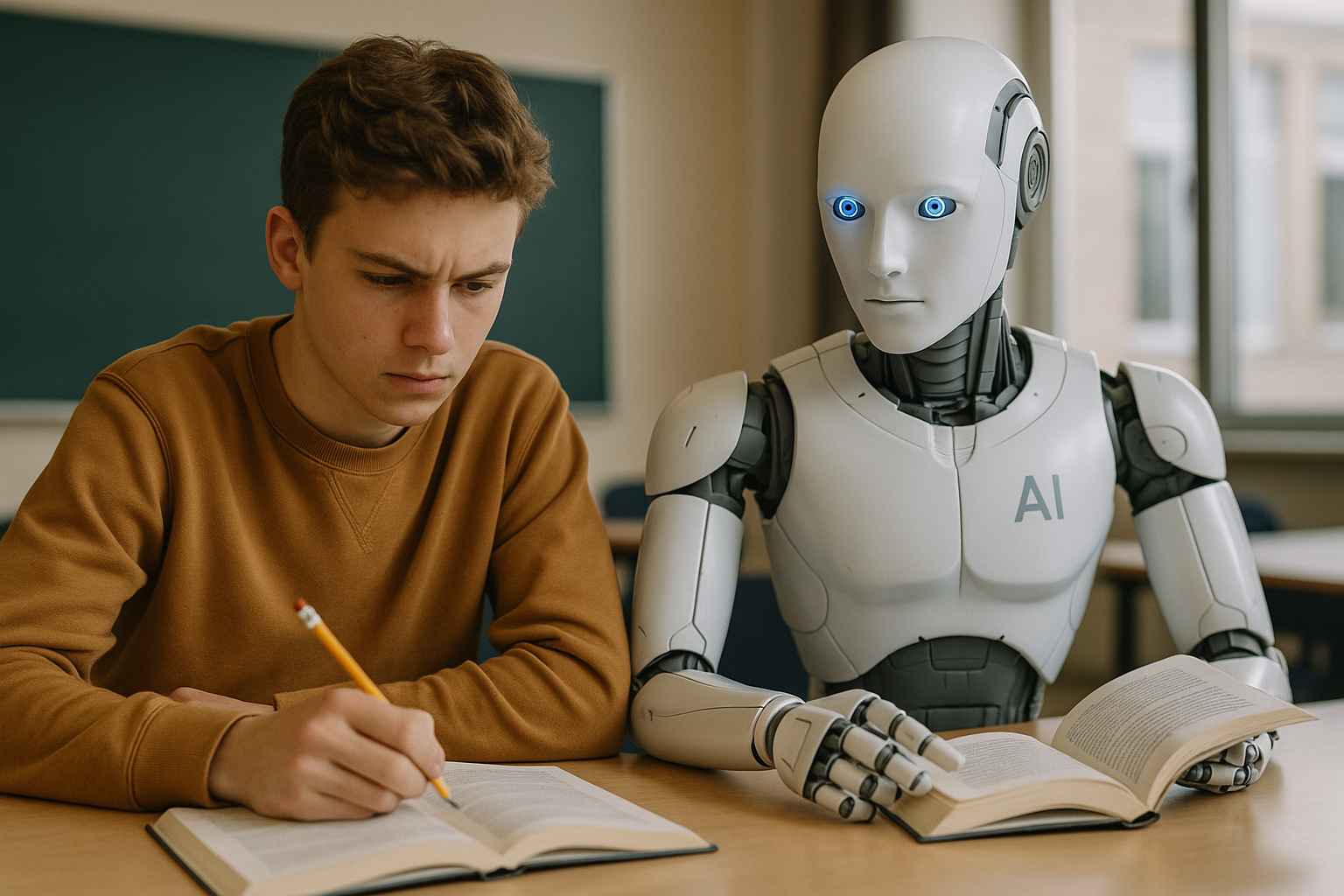

Shoshana Zuboff describe este nuevo orden como un capitalismo que coloniza la experiencia humana. Las plataformas transforman cada gesto en un dato y cada interacción en una oportunidad de predicción. En ese mundo, el software libre aparece como una anomalía política: una zona autónoma de cooperación no mercantil.

Pero incluso esa autonomía tiene límites. Los gigantes de la nube —Amazon, Google, Microsoft— basan su infraestructura en Linux, pero lo integran en un modelo de negocio cerrado. Es una paradoja: el código libre alimenta sistemas que luego privatizan sus beneficios. El ideal de Richard Stallman —un software controlado por sus usuarios— convive con un capitalismo que usa Linux como herramienta de dominio.

El software libre ganó técnicamente, pero el capitalismo ganó económicamente. Sin embargo, esa tensión no invalida la victoria de Linux: demuestra que la cooperación puede sostener la infraestructura de un mundo competitivo. La innovación ya no depende del mercado, sino de la comunidad.

5. El fin del modelo clásico de oferta y demanda

El modelo económico del siglo XX se basaba en un equilibrio entre productores y consumidores. Hoy, esa frontera se disolvió. Cada usuario produce datos que retroalimentan los servicios que utiliza. Somos al mismo tiempo clientes y materia prima. En esta economía circular del dato, el software libre introduce una excepción: permite usar sin ser usado.

La vieja noción de mercado —donde el precio reflejaba el valor— se quebró. En su lugar, aparece una economía de la dependencia continua: actualizaciones automáticas, servicios en la nube, suscripciones ineludibles. Linux, en cambio, sigue ofreciendo un modelo basado en la autonomía y la transparencia. No tiene precio porque no tiene propietario.

Yochai Benkler lo llamó producción entre pares: una forma de creación colectiva donde la motivación no es el lucro, sino el reconocimiento y el aprendizaje. Ese paradigma, marginal en los noventa, es hoy el que sostiene gran parte del ecosistema digital. El éxito de Linux demuestra que la colaboración abierta no solo es ética, sino económicamente viable.

6. La paradoja del software libre

Linux triunfó al desaparecer. Su invisibilidad es su fuerza. Está en el centro de la red, pero fuera del imaginario público. No tiene campañas, ni marketing, ni rostro corporativo. Su emblema —un pingüino sonriente— simboliza esa extraña mezcla de potencia y modestia: un poder que no necesita imponerse.

En un mundo donde todo se alquila, Linux sigue siendo de todos. En un entorno de control, sigue ofreciendo libertad. En un capitalismo que privatiza la infraestructura del conocimiento, Linux permanece como un recordatorio de que otra economía es posible: una basada en la cooperación, no en la propiedad.

Conclusión

El software libre no derrotó a Microsoft ni a Apple en el terreno visible. Pero mientras ellos compiten por la superficie, Linux sostiene el subsuelo. Es el latido técnico de Internet, la respiración de los dispositivos, la condición silenciosa del mundo digital. Su triunfo no se mide en usuarios, sino en presencia.

El capitalismo transformó el software en servicio y al usuario en recurso. Linux respondió con una lógica inversa: convertir el conocimiento en bien común y la cooperación en motor de progreso. No necesitó venderse, porque todos terminaron usándolo.

“El código libre no conquistó las pantallas: conquistó la respiración de las máquinas.”

Bibliografía orientativa

- Benkler, Yochai. The Wealth of Networks. Yale University Press, 2006.

- Castells, Manuel. La era de la información. Alianza Editorial, 1996.

- Raymond, Eric S. The Cathedral and the Bazaar. O’Reilly Media, 1999.

- Rifkin, Jeremy. La era del acceso. Paidós, 2000.

- Stallman, Richard. Free Software, Free Society. GNU Press, 2002.

- Zuboff, Shoshana. The Age of Surveillance Capitalism. PublicAffairs, 2019.

- Lessig, Lawrence. Code and Other Laws of Cyberspace. Basic Books, 1999.